À la mi-2016, Aviv Ovadya s'est rendu compte qu'internet avait un très gros problème —tellement gros qu'il a décidé d'abandonner son travail pour pousser un cri d'alarme. Quelques semaines avant les élections américaines de 2016, il a exposé ses inquiétudes à des professionnels du secteur des nouvelles technologies de la région de la Baie de San Francisco et averti de l'imminence d'une crise de la désinformation lors d'une présentation qu'il a intitulée «Infocalypse.»

Dans cet exposé, Aviv Ovadya expliquait que le web, et tout l'écosystème de l'information qui s'est développé autour, sont terriblement malsains. Les motivations qui régissent ses plus grandes plateformes sont calibrées pour récompenser des informations souvent trompeuses, polarisantes ou les deux. Des plateformes comme Facebook, Twitter et Google donnent la priorité aux clics, aux partages, aux publicités et à l'argent au détriment de la qualité de l'information, et Aviv Ovadya ne parvient pas à se débarrasser de la sensation que tout cela va déboucher sur quelque chose de néfaste : un genre de seuil critique de désinformation addictive et toxique. Cette présentation a été largement ignorée par les employés des plateformes des géants des nouvelles technologies — notamment par la petite équipe de Facebook qui devait s'atteler plus tard à mettre en place la nouvelle politique de Facebook pour assurer l'intégrité des fils d'actualité.

«À l'époque, c'était comme si on était dans une voiture qui fonçait à toute allure sans le moindre contrôle et que non seulement tout le monde disait “ça va aller”, mais qu'en plus personne ne voyait la voiture», explique-t-il.

Aviv Ovadya a vu très tôt ce que beaucoup —y compris des législateurs, des journalistes et des PDG des géants technologiques— allaient mettre des mois à comprendre : notre monde de plateformes, optimisé par des algorithmes, est vulnérable. Perméable à la propagande, à la désinformation, à la publicité ciblée malintentionnée de gouvernements étrangers. Au point qu'il menace de saper une des pierres angulaires du discours humain : la crédibilité des faits.

Mais c'est ce qu'il a anticipé qui donne vraiment des sueurs froides.

«L'alarmisme peut être une bonne chose, il faut être alarmiste pour ces trucs-là», nous explique Aviv Ovadya une après-midi de janvier, avant d'exposer calmement les grandes lignes d'une projection extrêmement dérangeante pour les vingt prochaines années, faite de fake news, de campagnes de désinformation assistées par l'intelligence artificielle (IA) et de propagande. «On est tellement dans la merde, c'est au-delà de tout ce que la plupart d'entre nous peuvent imaginer», expose-t-il. «Nous étions bien dans la merde il y a un an et demi et là nous y sommes jusqu'au cou. Et c'est de pire en pire à mesure qu'on regarde vers l'avenir.»

Cet avenir, selon Aviv Ovadya, adviendra accompagné de tout un tas d'outils technologiques sophistiqués, faciles à utiliser et, au final, indécelables qui serviront à manipuler la perception et à falsifier la réalité, et pour lequel des expressions ont déjà été inventés : «apathie face à la réalité», «phishing laser automatisé» et «marionnettes humaines.»

C'est pourquoi Aviv Ovadya, diplômé du MIT qui a travaillé en tant qu'ingénieur dans des entreprises technologiques comme Quora, a tout laissé tomber début 2016 pour tenter d'empêcher ce qu'il considère être une crise de l'information engendrée par les géants des nouvelles technologies. «Un jour, j'ai juste eu un déclic», dit-il au moment d'évoquer sa prise de conscience. Il est devenu clair à ses yeux que si quelqu'un devait exploiter l'économie de l'attention et utiliser les plateformes qui la soutiennent pour déformer la vérité, il n'existait aucun vrai moyen de contrôle ou de contre-pouvoir pour l'arrêter. «Je me suis rendu compte que si ces systèmes échappaient à tout contrôle, il n'y aurait rien pour les réfréner et que ça tournerait mal, très rapidement» explique-t-il.

«Nous étions bien dans la merde il y a un an et demi et là nous y sommes jusqu'au cou»

Aujourd'hui, Aviv Ovadya et tout un groupe de chercheurs plus ou moins affiliés à des établissements universitaires se tournent vers l'avenir avec inquiétude, vers un avenir à l'allure dangereusement dystopique. Ils mettent en scène des scénarios où ils simulent des guerres, basés sur des technologies qui ont commencé à émerger. Ce qui en ressort est, de manière générale, déprimant.

Pour Aviv Ovadya —aujourd'hui responsable nouvelles technologies du Center for Social Media Responsibility de l'Université du Michigan et membre du comité d'innovation Knight News du Tow Center for Digital Journalism de Columbia— le choc et l'inquiétude qu'ont généré les publicités russes sur Facebook et les bots sur Twitter font pâle figure au regard d'une menace bien plus inquiétante : les technologies susceptibles d'être utilisées pour augmenter et déformer la réalité évoluent plus vite que notre capacité à les comprendre, à les contrôler ou à en atténuer les effets. Les enjeux et les éventuelles conséquences sont plus catastrophiques qu'une ingérence étrangère dans une élection. Il s'agit de la sape ou du bouleversement d'institutions au cœur de notre civilisation : d'une «infocalypse». Et Aviv Ovadya affirme que celle-là est tout aussi plausible que la précédente —qu'elle serait pire encore.

Pire à cause de nos prouesses informatiques toujours plus étendues, pire à cause des avancées actuelles dans les domaines de l'intelligence artificielle et de l'apprentissage automatique qui peuvent brouiller les lignes entre les faits et la fiction, pire parce que ces choses pourraient faire naître un avenir où, comme l'observe Aviv Ovadya, n'importe qui pourrait «faire croire que quelque chose, n'importe quoi, est arrivé, que ce soit vrai ou pas».

«Que se passe-t-il quand n'importe qui peut faire croire que n'importe quoi est arrivé, ce que soit vrai ou pas?»

Et de même que l'avènement de campagnes de désinformation ciblées et soutenues par certains pays ne semblait pas plausible jusqu'au moment où on s'est rendu compte qu'elles étaient déjà en cours, Aviv Ovadya prévient que les outils qui se développent rapidement et fonctionnent grâce à l'intelligence artificielle, à l'apprentissage automatique et aux technologies de réalité augmentée pourraient être piratés et utilisés par des agents mal intentionnés pour imiter les humains et mener une guerre de l'information.

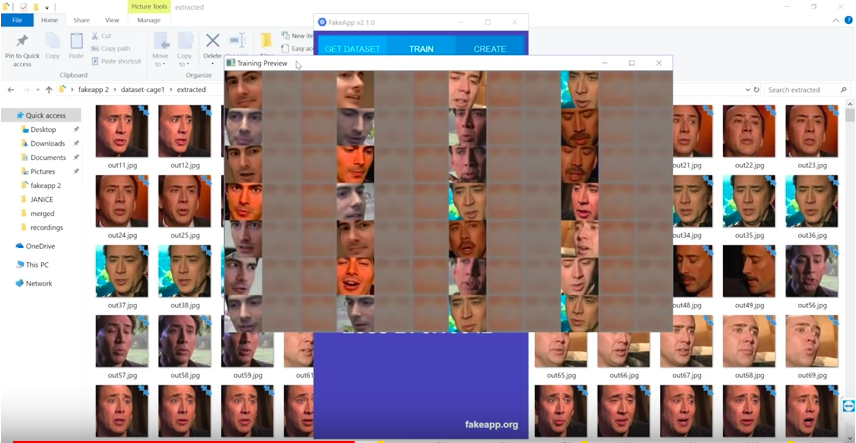

Et nous sommes plus proches qu'on ne pourrait le croire d'une potentielle «infocalypse». Certains outils disponibles pour manipuler des vidéos et des enregistrements audio, sont dans le domaine des fake news, de la même envergure que la bombe atomique dans le domaine militaire. Dans les recoins ténébreux d'internet, des gens se sont mis à utiliser des algorithmes d'apprentissage automatique et des logiciels open source pour créer facilement des vidéos pornographiques qui superposent de façon tout à fait réaliste les visages de célébrités —ou de n'importe qui d'ailleurs— et les corps d'acteurs pornos. Dans des institutions comme Stanford, des spécialistes des nouvelles technologies ont mis au point des programmes capables de manipuler des vidéos en associant et en mélangeant des séquences filmées et des techniques de suivi de visage. Dans le même genre, à l'université de Washington des informaticiens ont réussir à élaborer un programme apte à «transformer des séquences audio en vidéo réaliste et synchronisée de la personne qui parle». Pour prouver la validité du concept, les deux équipes ont manipulé des vidéos existantes où ils font dire à des chefs d'État des paroles qu'ils n'ont jamais prononcées.

Ces outils se démocratisent et deviennent de plus en plus répandus, ce qui pousse Aviv Ovadya à craindre le pire avec des scénarios qui pourraient s'avérer extrêmement déstabilisants.

Il cite par exemple la «manipulation diplomatique», où un agent malveillant utilise des technologies avancées pour «faire croire qu'un événement s'est produit» afin d'influencer la géopolitique. Imaginez par exemple un algorithme d'apprentissage automatique (qui analyse des masses de données pour s'enseigner à lui-même à accomplir une fonction particulière) alimenté par des centaines d'heures d'enregistrements de Donald Trump ou du dictateur nord-coréen Kim Jong Un, et qui serait ensuite capable de recracher un fichier audio ou vidéo quasi-parfait —et pratiquement impossible à distinguer d'un vrai— du dirigeant déclarant la guerre nucléaire ou biologique. «Cela n'a pas besoin d'être parfait, juste assez bien pour que l'ennemi pense qu'il s'est passé quelque chose afin de déclencher une réponse-réflexe irréfléchie en représailles.»

«Cela n'a pas besoin d'être parfait — juste assez bien»

Un autre scénario serait celui qu'Aviv Ovadya surnomme «simulation d'organisation politique». Il s'agit d'un mélange dystopique où se mélangent botnets —un réseau de bots informatique— et astroturfing —la simulation de phénomènes de masse sur internet pour influencer l'opinion publique— pour créer de fausses campagnes citoyennes qui manipuleraient les mouvements politiques. Dans la vision d'Aviv Ovadya, des bots animés par une intelligence artificielle et de plus en plus crédibles seront capables de rivaliser de manière efficace avec de vrais êtres humains pour attirer l'attention des législateurs et des autorités régulatrices. À ce moment-là, il sera devenu trop difficile de faire la différence entre les deux. En se basant sur d'autres situations où le discours public est manipulé, il sera peut-être bientôt possible d'encombrer directement les standards téléphoniques des membres du Congrès américain avec des requêtes crédibles, apparemment venues du fond du coeur mais en réalité générées par des algorithmes [aux États-Unis, les citoyens peuvent appeler leurs représentants directement au téléphone pour faire passer des messages, ndlt]. Dans le même genre, les boîtes mail de sénateurs pourraient se retrouver inondées de messages d'électeurs qui seraient des patchworks de textes, de fichiers audio et de profils de réseaux sociaux bricolés par des programmes d'apprentissage automatique.

Il y a aussi le «phishing laser automatisé», une tactique, souligne Aviv Ovadya, qu'évoquent déjà à voix basse les chercheurs spécialistes en sécurité. En gros, elle utilise l'intelligence artificielle pour analyser notre présence sur les réseaux sociaux par exemple, et pour élaborer des messages faux mais parfaitement crédibles qui auraient l'air d'être envoyés par des gens que nous connaissons. Ce qui change la donne, explique Aviv Ovadya, c'est qu'une chose comme le phishing laser permettrait à des personnes mal intentionnées de cibler n'importe qui et d'en créer une imitation crédible en utilisant uniquement des données accessibles au public.

«Avant, il aurait fallu un humain pour imiter une voix ou pour produire une fausse conversation à l'air authentique. Dans cette version, vous pourriez juste appuyer sur un bouton et utiliser un logiciel en open source», explique Aviv Ovadya. «C'est là que ça devient une nouveauté : quand tout le monde peut le faire parce que c'est banal. Là, c'est une tout autre paire de manches.»

Imaginez, suggère-t-il, des mails qui ne sont pas simplement des liens bizarres sur lesquels vous pouvez décider ou non de cliquer, mais un message personnalisé avec un contexte. «Pas juste un mail, mais le mail d'un ami que vous attendiez impatiemment depuis un moment», continue-t-il. «Et parce qu'il serait tellement facile de créer des faux, vous seriez submergé. Si tous les spams que vous receviez ressemblaient exactement à des mails de personnes réelles, que vous connaissez, chacun avec sa propre motivation essayant de vous convaincre de quelque chose, vous finiriez juste par vous dire “c'est bon, je vais ignorer ma boîte mail.”»

Tout ça peut mener à ce qu'Aviv Ovadya appelle «l'apathie face à la réalité» : assaillis par un torrent constant de désinformation, les gens abandonnent, tout simplement. Aviv Ovadya ne perd pas de temps pour nous rappeler que c'est courant dans des régions où l'information est de mauvaise qualité et où elle est donc généralement considérée comme incorrecte. La grande différence, souligne-t-il, c'est le choix de l'apathie par une société développée telle que la nôtre. Le résultat, redoute-t-il, n'est pas bon. «Les gens arrêtent de faire attention à ce qui se passe et le niveau fondamental d'information nécessaire à une démocratie fonctionnelle devient instable.»

Aviv Ovadya (et d'autres chercheurs) considèrent que le phishing laser est inévitable. «C'est une menace, sans aucun doute, mais le pire c'est que je ne crois pas qu'il y ait une solution pour l'instant», déplore-t-il. «Il va falloir construire des infrastructures à l'échelle d'internet pour arrêter ça, si ça se met en route.»

Au-delà de tout cela, il existe d'autres scénarios cauchemardesques à long terme qu'Aviv Ovadya estime «tirés par les cheveux», mais pas au point qu'il envisage de les écarter totalement. Et ils font peur. Les «marionnettes humaines» par exemple : une version clandestine d'un marché des réseaux sociaux, avec des gens à la place des bots. «Fondamentalement, il s'agit d'un futur marché transnational développé pour humains manipulables», explique-t-il.

Les prémonitions d'Aviv Ovadya sont particulièrement terrifiantes étant donné la facilité avec laquelle notre démocratie a déjà été manipulée par les techniques de désinformation brutales et rudimentaires. Les arnaques, les supercheries et le brouillage de piste à venir n'ont rien d'une nouveauté. Ils sont juste plus sophistiqués, plus difficiles à détecter et travaillent main dans la main avec d'autres forces technologiques qui ne sont pas inconnues aujourd'hui mais qui sont susceptibles d'être imprévisibles.

Pour ceux qui s'intéressent de près aux développements de l'intelligence artificielle et de l'apprentissage automatique, rien de tout cela ne semble exagéré. Un logiciel en cours de développement chez le fabricant de puces Nvidia est déjà capable de générer de façon convaincante des photos hyper-réalistes d'objets, de personnes et même de certains paysages en écumant des dizaines de milliers d'images. Adobe a aussi récemment piloté deux projets —Voco et Cloak— le premier étant un «Photoshop audio» et le second, un outil qui peut retirer en toute discrétion des objets (et des personnes !) de vidéos en quelques clics.

Dans certains cas, la technologie est tellement performante qu'elle va jusqu'à surprendre ses propres créateurs. Ian Goodfellow, un scientifique et chercheur Google Brain qui a contribué à coder le premier «réseau contradictoire générateur» (GAN), un réseau neuronal capable d'apprendre sans supervision humaine, a averti que l'IA pourrait renvoyer la consommation d'informations environ 100 ans en arrière. Lors d'une conférence de la MIT Technology Review en novembre dernier, il a expliqué au public que les GAN faisaient à la fois preuve «d'imagination et d'introspection» et «pouvaient prendre connaissance de l'état du générateur sans avoir besoin de feedback humain.» Et que si les possibilités créatives sont illimitées pour les machines, l'innovation appliquée à la manière dont nous consommons l'information «fermerait sans doute certaines des portes que notre génération a eu l'habitude de voir ouvertes».

Vu sous cet angle, les scénarios pessimistes d'Aviv Ovadya semblent tout à fait plausibles dans le champ politique notamment. Cet été, plus d'un million de faux comptes bots ont inondé le système de commentaires de la Federal Communications Commission, l'équivalent du CSA américain, pour «amplifier l'appel à abroger les protections de la neutralité du net.» Les chercheurs ont conclu que les commentaires automatisés —qui grâce à un traitement automatique reproduisent un style d'écriture naturelle pour avoir l'air réels— cachaient les commentaires authentiques et minaient la légitimité de tout le système de commentaires. Pour Aviv Ovadya, l'exemple de la FCC ainsi que la récente campagne #releasethememo sur le Twitter américain, amplifiée par les bots, est une version grossière de ce qui nous attend. «Ça peut être tellement pire», explique-t-il.

«Vous n'avez pas besoin de créer une fausse vidéo pour que cette technologie ait un impact sérieux. Il suffit de signaler le fait que la technologie existe pour mettre en doute l'intégrité de ce qui est réel.»

Cette érosion de l'authenticité et de l'intégrité du discours officiel est la plus sinistre et la plus inquiétante des menaces à venir. «Que ce soit l'IA, de drôles de manipulations Amazon ou du faux activisme politique, ces fondations technologiques (conduisent) à une érosion croissante de la confiance», explique Renee DiResta, chercheuse experte en propagande informatique, au sujet de la future menace. «Cela rend possible de jeter le doute sur l'authenticité de vidéos ou de plaidoyers.» DiResta évoque le récent démenti par Donald Trump que la voix sur le tristement célèbre enregistrement Access Hollywood était la sienne, citant des experts qui lui avaient dit qu'il était possible qu'elle ait été forgée numériquement. «Vous n'avez pas besoin de créer une fausse vidéo pour que cette technologie ait un impact sérieux. Il suffit de signaler le fait que la technologie existe pour mettre en doute l'intégrité de ce qui est réel.»

C'est ce qui explique pourquoi des experts en nouvelles technologies comme DiResta —qui a passé des années sur son temps libre à conseiller l'administration Obama, et aujourd'hui les membres du Senate Intelligence Committee, pour lutter contre les campagnes de désinformation lancées par les trolls— et Aviv Ovadya (bien qu'ils travaillent indépendamment l'un de l'autre) se mettent à davantage parler des menaces qui se précisent. La semaine dernière, le NYC Media Lab, qui aide les entreprises et les universités de la ville à collaborer, a annoncé le lancement d'un programme visant à rassembler des experts en nouvelles technologies et des chercheurs, en juin prochain, pour «explorer les scénarios du pire» pour le futur de l'information et des technologies. L'événement, qu'ils ont surnommé Fake News Horror Show, est annoncé comme «une foire scientifique d'abominables outils de propagande, certains réels et d'autres imaginaires, mais tous basés sur des technologies plausibles.»

«Au cours des deux, trois, quatre prochaines années, nous allons devoir gérer des propagandistes amateurs capables de gagner des fortunes en créant des simulations photos réalistes, extrêmement réalistes», explique Justin Hendrix, directeur exécutif du NYC Media Lab, à BuzzFeed News. «Et si ces tentatives fonctionnent, et que les gens en viennent à soupçonner qu'il n'y a aucune réalité sous-jacente aux objets médiatiques quels qu'ils soient, alors nous allons vraiment avoir des problèmes. Il suffira d'un ou deux gros hoax pour finir de convaincre le public que rien n'est vrai.»

Compte tenu des premières dénégations de l'efficacité de la désinformation —comme la déclaration à présent tristement célèbre de Mark Zuckerberg, le PDG de Facebook, selon laquelle il est «dingue» de dire que les fake news sur son site ont joué un rôle dans les élections de 2016— la première étape pour des chercheurs comme Aviv Ovadya est pour le moins impressionnante. Il s'agit de convaincre le grand public, ainsi que les législateurs, les spécialistes universitaires des nouvelles technologies et les entreprises technologiques, qu'une apocalypse de l'information faussant la réalité n'est pas seulement plausible mais qu'elle est proche.

«Il suffira d'un ou deux gros hoax pour finir de convaincre le public que rien n'est vrai»

Un haut fonctionnaire fédéral dont la tâche est d'enquêter explicitement sur la guerre de l'information, a expliqué à BuzzFeed News que même lui n'était pas certain du nombre d'agences gouvernementales qui se préparaient à des scénarios comme celui décrit par Aviv Ovadya. «Nous sommes en moins mauvaise position qu'il y a un an», estime-t-il, avant de souligner que c'est toutefois très loin d'être suffisant. «Je vois ça dans le sens des Lumières —qui se voulaient entièrement une quête de la vérité», raconte le haut fonctionnaire à BuzzFeed News. «Je crois que ce qu'on voit maintenant c'est une attaque contre les Lumières —et contre des documents qui en sont l'héritage, comme la Constitution— par des adversaires qui essaient de créer une société de la post-vérité. Et c'est une menace directe pour les fondations de notre civilisation actuelle.»

C'est une idée terrifiante, d'autant plus parce qu'il est tellement épineux de prévoir ce genre de choses. La propagande informatique est bien plus qualitative que quantitative : un scientifique spécialiste du climat peut montrer des données explicites démontrant une augmentation de la température, mais il est à peu près impossible de construire un modèle prédictif fiable évaluant le futur impact d'une technologie appelée à être perfectionnée.

Pour les spécialistes des nouvelles technologies comme le haut fonctionnaire fédéral, le seul recours est d'inciter vivement à la prudence, de bien peser les implications morales et éthiques des outils qui sont en train de se construire et, ce faisant, d'éviter le moment Frankenstein où la créature se tournera vers vous pour demander : «As-tu jamais considéré les conséquences de tes actes ?»

«Je suis issu de la culture de la liberté et de l'open source. L'objectif n'est pas d'arrêter la technologie mais de nous assurer que nous sommes dans un équilibre positif pour les gens. Donc je ne suis pas juste en train de crier : “ça va arriver”, mais je dis : “envisagez-le sérieusement, examinez les implications”», continue Aviv Ovadya. «Mon discours, c'est : “soyez assuré que ça, ça ne va pas ne pas se produire.”»

Une déclaration loin d'être encourageante. Ceci dit, Aviv Ovadya concède qu'il reste une petite place à l'optimisme. L'intérêt prêté à l'espace de propagande informatique est plus grand qu'il ne l'a jamais été, et ceux qui tardaient autrefois à prendre les menaces au sérieux sont aujourd'hui plus réceptifs aux avertissements. «Au début c'était vraiment sinistre —quasiment personne n'écoutait», se souvient-il. «Mais les derniers mois ont été réellement prometteurs. Certains contre-pouvoirs sont en train de se mettre en place.» De même, il y a des solutions envisageables —comme la vérification cryptographique des images et des fichiers audio, qui pourrait aider à distinguer ce qui est réel de ce qui a été manipulé.

Pourtant, Aviv Ovadya et d'autres avertissent que les prochaines années pourraient être difficiles. Malgré certaines promesses de réforme, il a l'impression que les plateformes restent régies par de mauvaises incitations sensationnalistes, où les pièges à clics et les contenus de mauvaise qualité sont récompensés en recevant plus d'attention. «C'est un casse-tête en général, et quand on l'associe à un système comme Facebook, qui est un accélérateur de diffusion de contenu, cela devient très dangereux.»

Reste encore à voir à quelle distance exactement nous sommes de ce péril. Interrogé sur les signes de danger qu'il guette, Aviv Ovadya garde le silence pendant un instant. «Je ne suis pas très sûr, en fait. Malheureusement, de nombreux signaux d'alarme ont déjà retenti.»●

Ce post a été traduit de l'anglais par Bérengère Viennot.