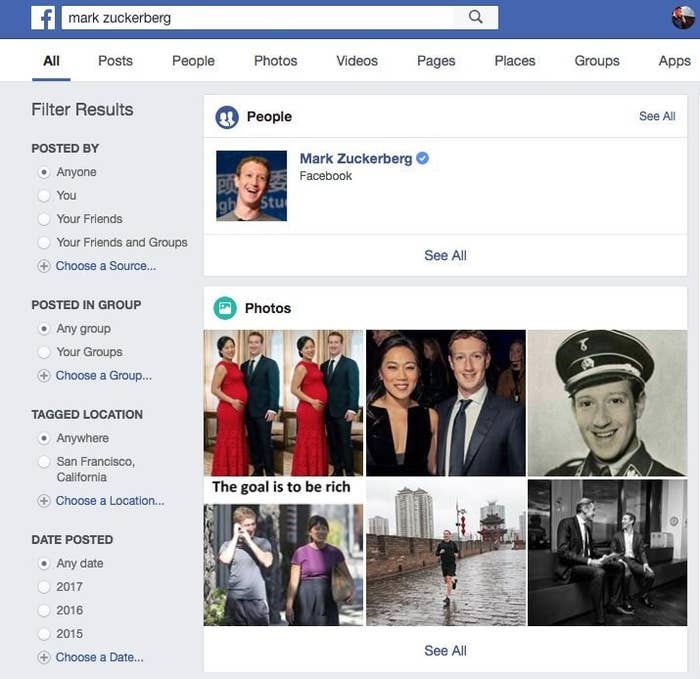

2017年のはじめのこと。Facebookでマーク・ザッカーバーグの名前を検索すると、予期しない結果が戻ってきた。ナチスの制服を着たFacebookの創業者が、正しいプロフィールとともに一番目に出てくるのだ。このフォトショップで加工された写真はFacebookに、この扇情的な写真を消去して情報検閲についての批判を受けるリスクをとるか、喜んでナチスの制服を着たCEOの写真を掲載し続けるかという、2つの選択肢を突きつけた。

どちらの選択肢もFacebookにとっては好ましいものではなかった。しかし、こういった状況は珍しいものではなかった。Facebookのコンテンツ・モデレーション(適正化)の決定は、一部は児童ポルノを削除したりするようなはっきりした論理的根拠に基づくものだが、その多くは、偽のザッカーバーグの写真同様、結論つけの難さと、緊張感をはらむ結果というジレンマに直面している。

これらの難しい選択と、Facebookのそれに対するアプローチの考え方は、Facebook社が前例のないコンテンツ・モレデーション(適正化)を拡大させている中で、非常に重要になっている。Facebookは20億人の利用者がいるプラットフォームであり、暴力的な内容、フェイクニュース、米国大統領選挙時にロシア政府支援が拡散した社会を分断をする投稿などへの同社の対応を社会が厳しく批判した結果、4000人の新しいモデレーター(不適切と判断された投稿を編集または削除する担当者)を雇用しようとしている。

グレーゾーンにあるコンテンツへの判断は、同社の成長過程で必要だと議論されては消えてきた重要なものである。そのグレーゾーンのコンテンツにたいする判断が可能になるという点で、モデレーターは同社に価値をもたらすだろう。

ますます監視体制を強化しているFacebookは今、その広大なプラットフォームにおいて、人種差別やヘイトスピーチ、誤報、プロパガンダ、ザッカーバーグにナチス制服を着せたフォトショップ写真といった最も難しいコンテンツの問題をどう論争していくかという、難しい問題に直面している。

「世界には本当な多様な人々がいて、何をネット上でシェアするのが妥当かは人によって考え方が大きく異なります。そういった世界に線を引こうとしているのです」とFacebookのグローバルプロダクトポリシー部門長のモニカ・ビッカート氏はBussFeed Newsに語った。

Facebookが直面している多くの厄介な問題の中のうちいくつかは、11月のワシントンでの公聴会で持ち上がった。その公聴会にはFacebook、Google、Twitterが呼ばれ、彼らのプラットフォーム上で行われた2016年の大統領選におけるロシア政府の操作について議会と議論した。議員からの厳しい尋問の中で、これらのプラットフォームの弁護士は何度も、こういった問題に善処することを約束した。

しかし、Facebookがどうやって約束を執行すべきかということは、主要な質問を残している。「答えを出し難い、無数のジレンマがあるはずです。ロシアのテレビネットワークの『RT(旧称ロシア・トゥデイ)』のような会社への対応ですら難しいでしょう」と下院情報特別委員会のトップの一人であるアダム・シフ議員は公聴会の後でBuzzFeed Newsに語った。

RTは米国のインテリジェンス・コミュニティーによって、ロシア政府第一の国際的なプロパガンダ企業だといわれてきている。Facebookにとって厄介な問題を生み出す企業であり、ロシア政府が2016年の大統領選を混乱させることを可能にしたとFacebookが国会で激しく非難された原因となった。FacebookはRTのコンテンツをプラットフォーム上で制限する権限を持つ。しかし、その決断は悩ましい。RTのコンテンツがFacebook上で行き交うことを許すということは、つまり事実上Facebookをプロパガンダを届ける仕組みに変えてしまう。一方でRTを沈黙させることは、世の中の人々が多くの議論を交わす場を提供しているというプラットフォームとしての立場では、自由な表現を抑制するという重大な結果ももたらす。

デトロイト・マーシー大学で合衆国憲法修正第一条(表現や宗教の自由を規定)を研究しているカイル・ラングヴァルド准教授はFacebookのようなプラットフォームから政治的なコンテンツを削除する危険性を指摘している。「民間企業がコンテンツの削除を判断し、その企業がどんどん公共領域をコントールしているとすれば、国家に対して決して許さなかった公共領域での言論規制を、本質的には民間企業に許すことになります」と彼は語る。

ラングヴァルド氏が指摘しているように、Facebookが政治的発言を規制することから持ち上がりうる問題は、非常に厄介だ。このプラットフォームは毎月20億人以上に使われており、ピュー・リサーチセンターによると、45%のアメリカ人はニュースをFacebookのフィードで得るという、事実上の「町の広場」的存在になっている。Facebookのコンテンツの削除権限に関しては、ほとんど抑制がない。Facebookは削除したコンテンツについての記録を公表していないので、第三者が規制決定について真意を知ることはほとんど不可能だ。「多くの点で、これらの企業が政府ではないという事実が、その行動をさらに不安なものにします。もし彼らが政府であれば、少なくとも人々に対し、政治プロセスの説明責任を負うのですから」とラングヴァルド氏は語る。

とはいえ、Facebookは少なくとも透明性の向上に関心を持っているようだ。広報担当者は「私たちは、Facebook上の問題を含むコンテンツへの対応について、もっと透明性をもたせたいと思っています。現在、方法を検討中です」と語っている。

Facebookは現時点では、RTへの対応を他のコンテンツと変えていないとビッカート氏は説明する。「ロシア政府とRTとの関係は、弊社にとっては不適当とは言えません。もしFacebookのポリシーに反するものを公表するとしたら、私たちはそれを削除するでしょう」と彼女は言う。Twitterは2016年の米国選挙広告のうちの15%を300万ドルで提供しようとした後で、RTからの広告掲載を禁止したが、FacebookはTwitterとは異なり、RTが広告を掲載することを許し続けている。

ワシントンの公聴会で議論された話題の一つであるフェイクニュースはFacebookにとって上記のトピック同様、更に扱いにくくなっているだろう。虚偽の情報がミャンマーのロヒンギャ族の民族集団の殺人に貢献したかもしれないという批判が寄せられているためだ。この出来事が報道された時、人々はFaceookが大量虐殺を促進していると非難した。この問題に対処するための緊急チームの設置を求める人もいた。しかし、ここでも適切な対策は即座に明らかにはなっていない。Facebookがミャンマーについての虚偽のコンテンツを削除するための緊急チームを展開していた場合、Facebookは本社から何千キロも離れた場所での紛争に対し、やっつけの判断を下さなければならなかった。そして実際、Facebookがついに行動を起こし、ロヒンギャの村々での軍の活動を記録したいくつかの記事を削除した時、ロヒンギャの活動家はそれを民族浄化の証拠を消すものだとして非難した。

Facebookはその思想的に、虚偽のコンテンツを本来は削除したくはない。「民間企業が真実の決定者になることを望む人がいるとは思えません。人々はFacebookを、誰かと繋がりたいから使用するのです。人々が見るコンテンツはその個々人の選択の結果です。私たちは人々の安全を守るべく、ガイドラインを書いています。私たちのコミュニティーに、彼ら自身が関わるコンテンツを決定して欲しいと考えています」とビッカートは言う。Facebookは最近、フェイクニュースの拡散を制限する多数の施策を導入したが、その結果は今のところ不完全である。

明確なガイドラインがあっても、規制は難しいだろう。Facebookのようなプラットフォームで、婉曲表現を使って行われる嫌がらせをどうやったら適正化できるだろうか。教育的、歴史的な文脈で使われる人種差別的な中傷をどのように扱ったらいいのだろうか。風刺的な文脈における、かぎ十字をどのように扱ったらいいだろうか。そして、Facebookは政治的な発言を制限することに対しては反対だと言う明確な立場を表明してはいるが、政治的な意見は依然として、攻撃的な発言を禁止する等のFacebookのルールに反していないかという点で、モデレーションチームの監視対象になりうる。

裁量の範囲を考えると、検閲と、虚偽の情報やヘイトスピーチ、虐待的なコンテンツの積極的な削除との間には微妙な境界線がある。より積極的なプラットフォームが、どんなものなのかの兆候をすでにTwitterで見ている。TwitterはFacebookに似たルールを持っているが、嫌がらせを無視し続けた長い歴史を経て、もっと干渉主義的なアプローチを取っている。Twitterのアカウントの制限、凍結、削除という最近の取り組みは、両陣営から数人以上の人々が不公平に沈黙していると主張してはTwitterから離れていくと言う二次的な影響をうけて始まった。「差別主義者の少女を通報したら、Twitterが私のアカウントを12時間にわたって凍結した」ととあるユーザーが10月に証言していたが、このプラットフォームにとってそれはもう驚くようなことではない。

FacebookはTwitterよりもライトな対応をしてきたが、過去1年の間違いは、詳細に調査し、冷酷にそのまま放っておいたことだ。「Facebookだけでなく、すべての主流のソーシャルメディアのプラットフォームの取り組みは、ある意味で今までにないような厳しい衆人環視のもとに置かれていると言えます」と、UCLAの助教授で7年の間コンテンツ規制について研究をしているサラ・ロバーツ氏はBuzzFeed Newsに語った。「善かれ悪しかれ、Facebookは大衆の厳しい詮索に耐えているように見えます」

さらに、Facebookがコンテンツ規制の適切なバランスを見出そうとしていることも、一つの課題である。それは、何千人ものモデレーターが同じページに対して同じルールを首尾一貫して適用し続けるられるかという課題だ。

初期のFacebook社員で、同社の最初のコンテンツ規制の取り組みを支援したデイビッド・ウィルナー氏はそれが仕事の中で一番難しい部分だと語った。「ほとんどの場合、常識は本物ではないのです。たしかに、例えば泣いている赤ん坊を助けることなど、多くの人が良いと考える基礎的な傾向はあります。しかし、非常に基本的な人間性の問題という大まかなこと以上のことになると、『当たり前の合意』というものはないのです」とウィルナー氏はいう。「全ての人は、自分の経歴、幼年時代や人種、宗教、国籍、政治的見解、それらすべてを踏まえて意思決定をします。もしあなたが友人10人に頼んで50の難しい例をそれぞれで判断することにしたら、議論するよりもなく、友人たちは多くの意見を異ににするでしょう。それを実際に試してみたので、わかっているのです」

問題を攻撃的な姿勢で対処しようとする姿勢が、過去のFacebookに見られた。もし、その姿勢が、強い公的圧力を受け実施される新たなコンテンツ規制においても行われたら、悲惨な事態をもたらしかねない。Facebookはすでに「dyke(レズビアンの蔑称)」を自分自身について使っているなどの、蔑称として使っていない場合にも広く投稿を取り下げるということを今年初旬に行い、このやり方が問題を引き起こすことを実証している。多くの文脈を判断すると、「dyke」が必ずしも蔑称ではないことを踏まえ、facebookは多くの投稿を復元したのだった。

しかし、Facebookがナチスの制服を着ているように加工されたザッカーバーグの写真に対する取り扱いを見る限り、同社はデリケートなコンテンツの問題に対して、もっと繊細なアプローチを取るようになったようだ。

Facebookはその画像を削除せず、プラットフォーム上に残した。しかし、画像は「マーク・ザッカーバーグ」の検索結果の上位には、もう表示されていない。広報担当によると、サイト全体でザッカーバーグの検索結果の妥当性を向上するためにアップデートが行われたという。

この記事は英語から翻訳されました。翻訳:フェリックス清香 / 編集:BuzzFeed Japan